Как работает разметка данных

Сегодня хочу вас обрадовать: вы все уже давно работает на искусственный интеллект. Cейчас объясню почему.

Набившее оскомину выражение «данные – это новая нефть» особенно верно, если вспомнить, что сама по себе нефть, сырая, - вы особенно не сможете нигде применить. Ее надо очистить и переработать. Точно также дело обстоит и с нашей новой нефтью, информацией. Даже собрав большое количество неструктурированных данных, вы не сможете никак их применить в работе. И здесь появляется новый сегмент работы в области машинного обучения – разметка данных, data labelling.

Пусть объем этого рынка пока сравнительно небольшой - по оценке аналитиков из Cognica Research в 2023 году он достигнет 1,2 млрд. долларов США, работа по разметке данных занимает до четверти всего времени на реализацию ML-проектов. Плюс, как вы увидите дальше, не факт, что мы когда-либо сможем достоверно узнать, сколько реально тратиться денег на data labelling.

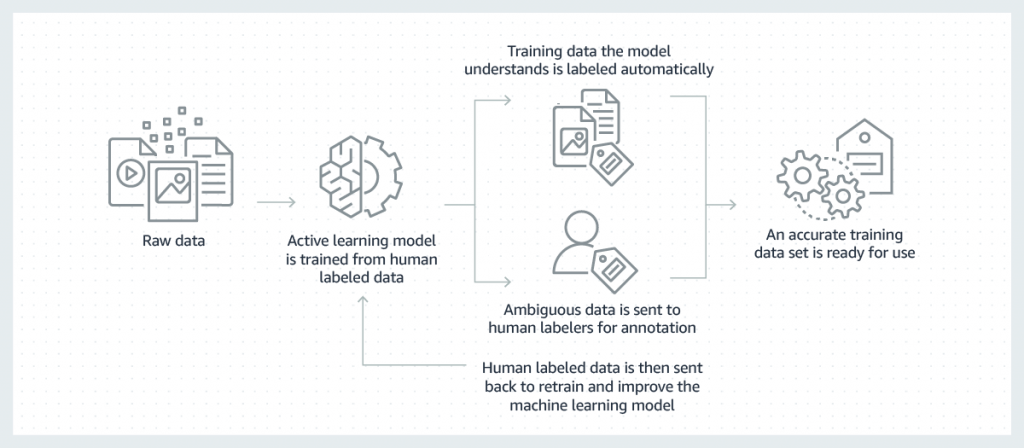

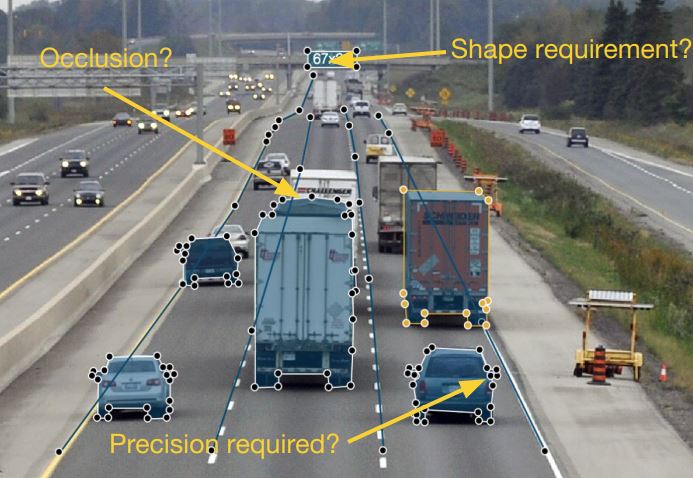

Итак, что же это такое – разметка данных? Основной задачей машинного обучения является обучение алгоритма – будь то традиционные статистические модели или новые нейронные сети, - искать и использовать закономерности из обучающего набора вопросов и ответов. При этом эти вопросы и ответы могут быть в виде текста, в виде изображения, в виде аудио или видео файла. К примеру, мы хотим научить модель определять тональность голоса человека, который звонит в колл-центр. Тогда вопрос будет звучать: какая интонация у звонящего? А ответами – положительная или негативная. Такие же примеры можно привести про видеозаписи, которые фиксируют нарушение автомобилем линии STOP перед светофором или нарушение привычной формы органа на рентгеновском снимке пациента. Чтобы искусственный интеллект научился давать правильные ответы на эти вопросы, за него это задачу сначала должен решить человек. То есть человек должен подготовить данные для машинного обучения. Это и разметка данных.

Теперь вы понимаете, почему data labelling— самая трудозатратная задача при создании решений на базе искусственного интеллекта: надо без ошибок разметить тысячи единиц информации и сделать это нужно быстро.

Как и в случае, когда нужно было генерить большой объем программного кода и Индия оказалась самым подходящим ресурсом для этого и стала (и остается) лидером в области оффшорного программирования, так и в случае с разметкой данных основной ресурс находится в Азии. Прежде всего это Китай, в котором миллионы сотрудников, без квалификации или с низкой квалификацией и маленькой заработной платой, ежедневно отсматривают десятки и сотни тысяч данных и размечают ее. Так что старая картинка с шуткой о сервисе распознавания музыкальных треков Shazam, где в огромном зале в наушниках сидят сотрудники и один из них кричит: «Кто-нибудь знает, чья эта песня?» не так уж далека от истины. Каким бы умным ни был искусственный интеллект, он ничто без человека. Смею надеяться, что так будет еще очень долго.

Несмотря на то, что количество данных растет, пока нет полноценных средств автоматизации для процесса разметки данных. Да, появляются решения, которые частично облегчают процесс – такие, например, как MarkLab, Handl, Annotate.online, Clarifai, - но все равно пока главная роль отдана человеку. Именно поэтому на рынке – и за рубежом, и в России, - появилось большое количество компаний, которые предоставляют услуги по разметке данных, нанимая фрилансеров, работающих из дому из всех точек земного шара.

Крупные поставщики инфраструктуры данных также создали хабы для разметки данных. В Штатах лидирует решение от Amazon, Amazon Mechanical Turk, названное в честь уловки 18 века, когда было модно играть в автоматизированные шахматы, хотя в ящике под шахматным столом сидел человек и физически передвигал фигуры. В России более популярна площадка Яндекс.Толока, которая, как и механический турок позволяет свести заказчиков наборов данных, датасетов, и специалистов по разметке данных.

Пару слов о том, как этот процесс работает. Все очень просто: клиент загружает «грязные» данные, выбирает шаблон задачи – классификацию, сегментацию, ввод текста, - и запускает процесс. Площадка сама находит исполнителей и выдает потом заказчику размеченные данные. Для справки, примерная стоимость такой работы у Яндекса – 15 долларов США за 1000 заданий, длительностью около 3 часов. Площадка берет себе около 20% комиссионных. Наверно, не так много, но за время самоизоляции многим очень пригодилась такая работа на дому.

Напоследок, как обещала, расскажу, почему мы с вами все работаем на искусственный интеллект. Вспомните, как при доступе на некоторые сайты, Google просит вас отметить все светофоры или автомобили (по крайней мере, мне он подсовывает именно их)? Так вот, каждый раз, когда вы кликаете по частям автомашин и горящих светофоров, вы работаете специалистом по разметке данных. Где же только наши 15 долларов?

Источник: Tadviser